Hoje, enquanto assistia ao nascer do sol da minha varanda e refletia sobre a quantidade absurda de energia que nossa estrela – o Sol – nos entrega a todo instante, não pude deixar de pensar o quanto nossa civilização – totalmente dependente da tecnologia – ainda luta para suprir uma demanda cada vez mais crescente por energia.

Pela Escala de Kardashev, criada pelo astrofísico russo Nikolai Kardashev em 1964, que classifica as civilizações em 3 tipos, com base na quantidade de energia que elas são capazes de coletar e utilizar, a Terra sequer atingiu o status de Tipo I (civilização planetária). Ou seja, ainda não conseguimos utilizar toda a energia disponível no nosso próprio planeta, incluindo a energia solar, geotérmica, eólica, entre outras. Uma civilização do Tipo II (civilização estelar) conseguiria aproveitar toda a energia emitida por sua estrela principal (no nosso caso, o Sol). E uma civilização do Tipo III (civilização galáctica) conseguiria obter energia além de sua própria estrela principal (no nosso caso, outras estrelas ou fontes de energia da Via Láctea).

Em tempos de expansão e crescimento do uso da Inteligência Artificial (IA), o consumo cada vez maior de energia torna-se um desafio para as big techs, com grande impacto no aquecimento global.

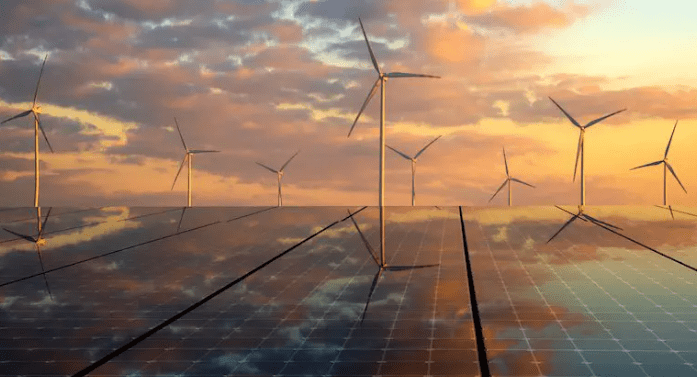

Sim, o consumo de energia elétrica está crescendo no mundo todo. A previsão de crescimento para 2024 é de 3,3% – em 2023 o crescimento foi de 2% – segundo relatório do Mercado de Eletricidade da IEA (Agência Internacional de Energia). Mesmo com um crescimento líquido de aproximadamente 84% do uso de fontes renováveis – como hidrelétrica, solar, eólica e biomassa – em 2023, essas fontes representavam apenas cerca de 14% da matriz energética mundial. Você já parou para pensar no quanto a IA consome de energia?

A IA utiliza complexos algoritmos de aprendizado de máquina, especialmente aqueles de aprendizado profundo (deep learning), que exigem uma quantidade significativa de poder computacional. Para treinar modelos de aprendizado de máquina, é necessário processar grandes volumes de dados, envolvendo operações matemáticas complexas e repetitivas que demandam muito poder de processamento e, consequentemente, muita energia, por longos períodos. O treinamento de modelos complexos pode levar dias ou até semanas, durante os quais os recursos computacionais são utilizados continuamente.

A demanda por poder computacional é crescente e, por vezes, somente as CPUs das máquinas, por mais potentes que sejam, não são suficientes, exigindo a coparticipação das GPUs (unidades de processamento gráfico), que são mais eficientes para esse tipo de tarefa do que as CPUs tradicionais, porém consomem muita energia. E não se trata apenas do alto consumo de energia pelos computadores. A infraestrutura de data centers que hospedam os recursos computacionais precisa de sistemas de resfriamento e manutenção que contribuem para o consumo de energia associado ao uso da IA.

O alto consumo de energia pelo treinamento e uso de IA contribui para as emissões de carbono, especialmente se a energia utilizada provém de fontes não renováveis. Isso agrava o problema do aquecimento global, tornando-se um desafio prioritário para as big techs a busca por eficiência energética e a transição para fontes renováveis de energia.

Então, como as big techs estão enfrentando esse problema?

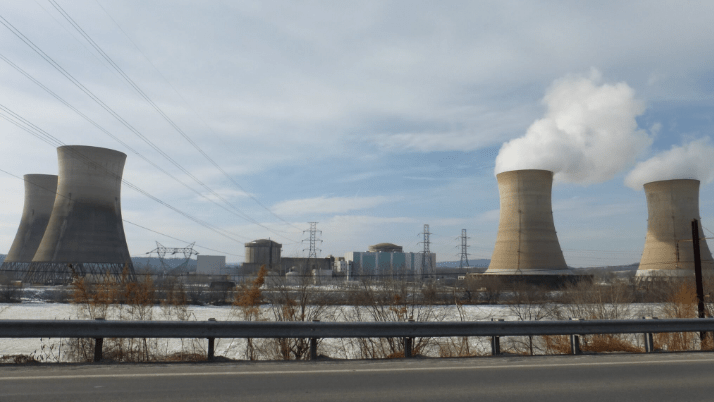

Além de utilizar-se de parques eólicos e usinas solares, um acordo anunciado entre o proprietário da usina nuclear de Three Mile Island e a Microsoft permitirá a reabertura da usina para geração de energia que será comprada integralmente pela Microsoft pelos próximos 20 anos. O acordo da Microsoft para ajudar a reativar a usina nuclear de Three Mile Island está diretamente relacionado à necessidade crescente de energia para seus data centers, especialmente devido à expansão da IA. A Microsoft tem um compromisso de se tornar carbono-negativa até 2030. Utilizar energia nuclear, que é uma fonte de energia livre de carbono, ajuda a empresa a atingir esse objetivo.

Um dos reatores dessa usina, a Unidade 2, sofreu uma fusão parcial em 1979, no que ainda é o acidente nuclear mais significativo da história dos Estados Unidos. Desde então, permaneceu fechada.

A OpenAI (criadora do ChatGPT) utiliza a infraestrutura da Microsoft para suas operações, uma vez que a Microsoft é um dos principais investidores da OpenAI e fornece suporte através de sua plataforma Azure, que tem compromisso de usar 100% de energia renovável em seus data centers até 2025, além da própria OpenAI estar trabalhando para tornar seus algoritmos mais eficientes em termos de energia, o que ajuda a reduzir o consumo de energia e as emissões de carbono.

Por sua vez, o Google tem investido significativamente em energia renovável, tendo anunciado em 2020 a compra de energia renovável suficiente para cobrir 100% de seu consumo anual de eletricidade. Curiosamente, também tem usado a própria IA para otimizar o consumo de energia em seus data centers. Os algoritmos de IA ajudam a prever e gerenciar a demanda de energia, melhorando a eficiência operacional. Apesar dos esforços, no entanto, a demanda crescente por IA tem levado a um aumento significativo no consumo de energia e, consequentemente, nas emissões de carbono.

As emissões de carbono do Google aumentaram quase 50% entre 2019 e 2023 devido ao aumento da demanda de energia para a IA.

A Amazon está adotando várias estratégias para suprir a crescente demanda de energia para suas operações de IA, prevendo investir quase 150 bilhões de dólares nos próximos 15 anos para expandir seus data centers, visando atender à explosão de demanda por aplicações de IA e outros serviços digitais. A AWS (Amazon Web Services) está comprometida em alcançar zero emissão líquida de carbono até 2040 e, para isso, está em fase de transição de sua infraestrutura para usar 100% energia renovável. Mesmo usando a própria IA para otimizar o consumo de energia em seus data centers, a demanda crescente por IA continua a representar desafios significativos com o aumento crescente de energia elétrica e, consequentemente, com o impacto ambiental.

Embora a Amazon tenha investido significativamente em projetos de energia renovável, a produção atual ainda não cobre completamente o consumo total de energia da empresa.

Apesar dos investimentos em energia renovável e das iniciativas para otimizar o consumo, a demanda crescente por IA e serviços em nuvem continua a pressionar as empresas de tecnologia a buscar soluções mais sustentáveis. A questão é: até que ponto as empresas conseguem acompanhar esse ritmo acelerado de crescimento, sem comprometer seus objetivos de sustentabilidade?

Você sabia?

Um artigo da Carnegie Mellon University – ainda a ser revisado por pares – baseado em estudos recentes, mostra que a geração de uma única imagem por IA pode consumir uma quantidade significativa de energia. Em média, gerar 1.000 imagens por IA consome cerca de 2,907 kWh, o que equivale a aproximadamente 0,0029 kWh por imagem. Isso é comparável a carregar a bateria de um smartphone até cerca de 24% de sua capacidade!

E nós, como usuários finais, qual o nosso papel nessa equação?

Como usuários, podemos contribuir informando-nos sobre o impacto ambiental das tecnologias que utilizamos e compartilhando esse conhecimento com outros. A conscientização é o primeiro passo para a mudança.

Ao escolhermos produtos e serviços que priorizam a sustentabilidade, estamos incentivando as empresas a investirem em soluções mais limpas e eficientes. Ao mesmo tempo, é fundamental que as grandes empresas de tecnologia assumam um papel de liderança, investindo em pesquisa e desenvolvimento de tecnologias que minimizem o impacto ambiental da IA.

A energia nuclear, embora seja uma fonte de energia livre de carbono, apresenta desafios em termos de segurança e gestão de resíduos. É preciso buscar soluções inovadoras que combinem a eficiência da energia nuclear com a segurança e a sustentabilidade das fontes renováveis.

Voltando à minha reflexão inicial, acredito que o ideal seria que, em um futuro próximo, atingíssemos a classificação de Tipo I na Escala de Kardashev. Embora isso possa parecer utópico no momento, será um marco evolutivo significativo para nossa civilização quando ocorrer.